去年上了古槿老师的概率图的课,受益匪浅,但是过了大半年没有接触又忘了许多,所以打算重新复习一番,希望能有新的体悟。

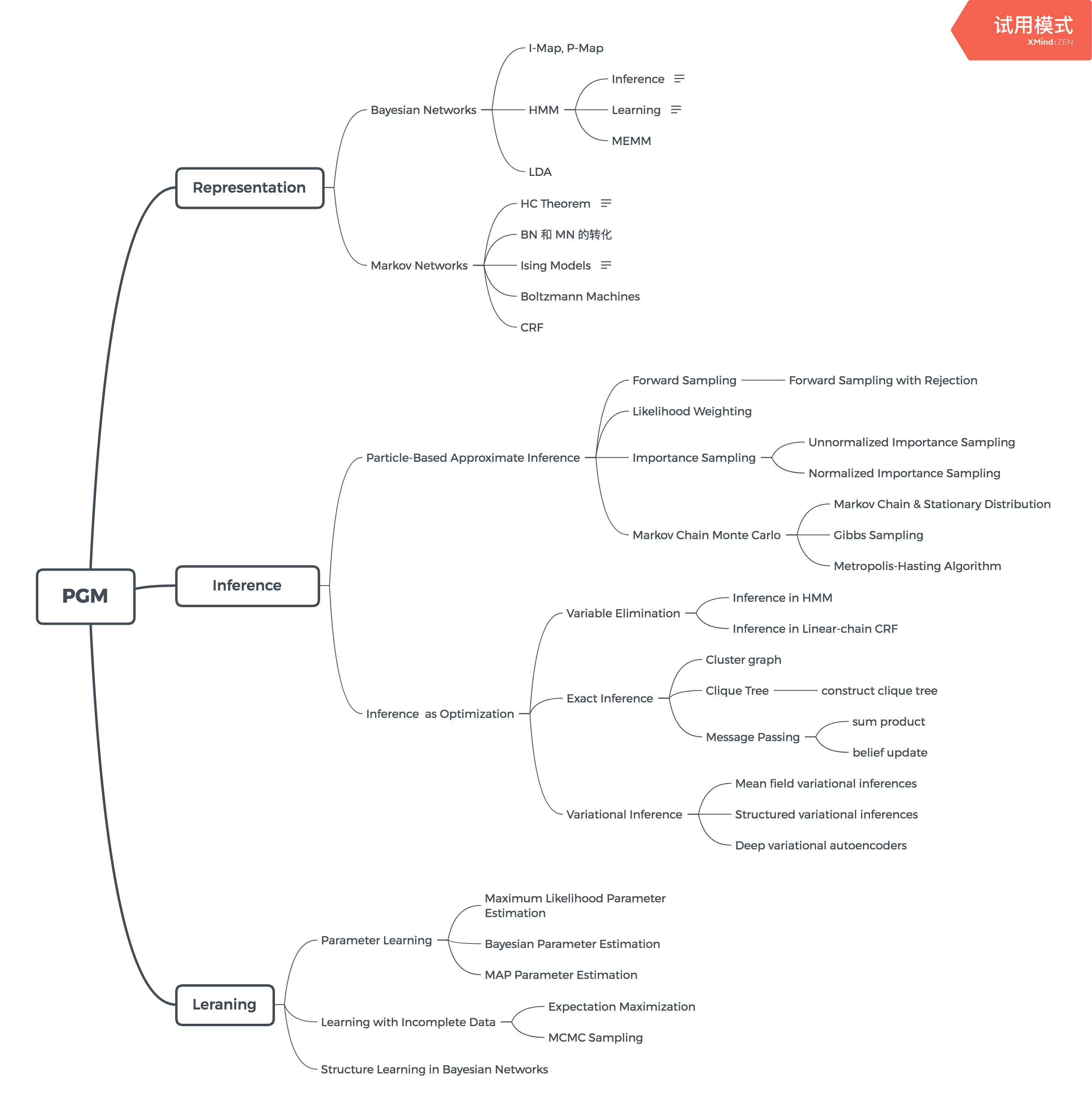

PGM 中的结构,画出来感觉结构会清晰很多

Introduction to PGM

Probability: decision making based on probability

如果有n个因素会影响最后的决策,那么参数的个数会呈指数型的增长,如果因素是二值的,那么会有 个参数,但如果是用一个graph来表示n个因素的关系,将会大大减少参数量,这也是为什么概率图产生的原因吧

Probability 的基础:

- Frequentist probability:

- Bayesian probability: 定义一些先验概率,就能计算一些后验概率

- 相关名词:random variable,joint probability,marginal probability,conditional probability,probability function,probability density function,independence,conditional independence

- Chain rule:

- 全概率公式:

- Bayes’ theorem:

Graph 的基础

- G(V, E): node/vertex, edges

- path, trail, connectivity

- Polytree, tree, chordal graph

- Centrality: degree, betweenness, closeness

- Subgraph, cut, clique

PGM的应用场景

这几个也是面试时候会问的,毕竟日常场景使用会比较多

- HMM:股票市场指数

- VAE:Dimension Reduction

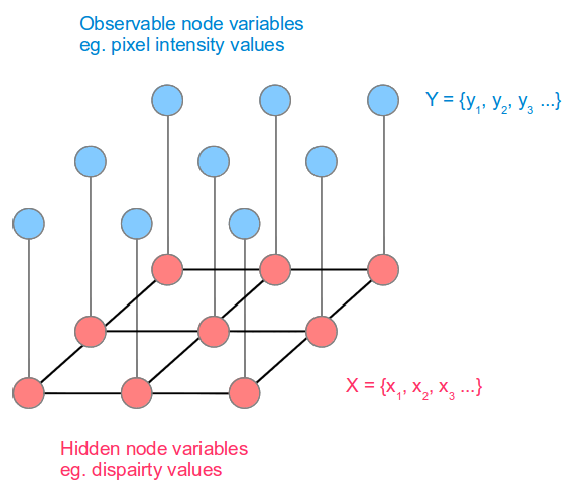

- CRF: 图像分割,后面章节其实提到了是Ising model,但没有想到是用来作图像分割的

隐变量和它临近节点是有相似值,因为图像在同一块区域一般不会有突变

- CNN:计算机视觉,举这个例子感觉和PGM不是很扯的上边

古老师分了十一个章节来阐述PGM,而且特别注重Representation,当时上课感觉这个层层递进,老师讲的也特别清楚,希望一章一章能逐步复习完,加油!

- Representation

- Chap1 Introduction

- Chap2 Bayesian Network

- Chap3 Local Probabilistic Model

- Chap4 Dynamic Bayesian Networks

- Chap5 Markov Random Fields

- Chap6 Advanced Models

- Inference

- Chap7 Variational Inference

- Chap8 Particle Based Approximate Inference

- Chap9 MAP Inference

- Learning

- Chap10 Bayesian Netowrk Learning

- Chap11 Learning with Incomplete Data

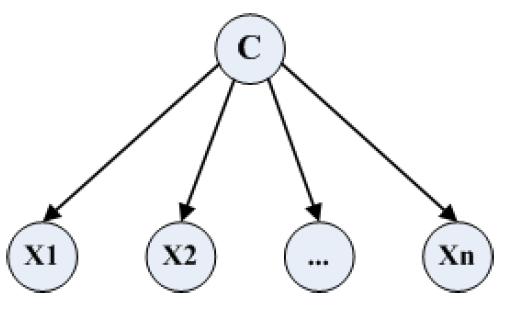

Naive Bayesian Model

如果类标签给定了,那所有的观测变量都是独立的

Representation: 其中G代表有向图,H代表无向图

Inference:

Learning: